通过完全在客户端运行该模型的方式可实现对运行速度的需求 , 即在使用 TensorFlow.js 的浏览器中运行且在初始页面加载后不需要服务器调用 , 也不需要安装任何依赖项 。

文章图片

MoveNet 可以通过快速动作和非典型姿势跟踪关键点 。

文章图片

传统方案(上)与 MoveNet(下)在高难度姿态检测上的对比结果 , 传统方案会跟丢关键点 , 而 MoveNet 不会

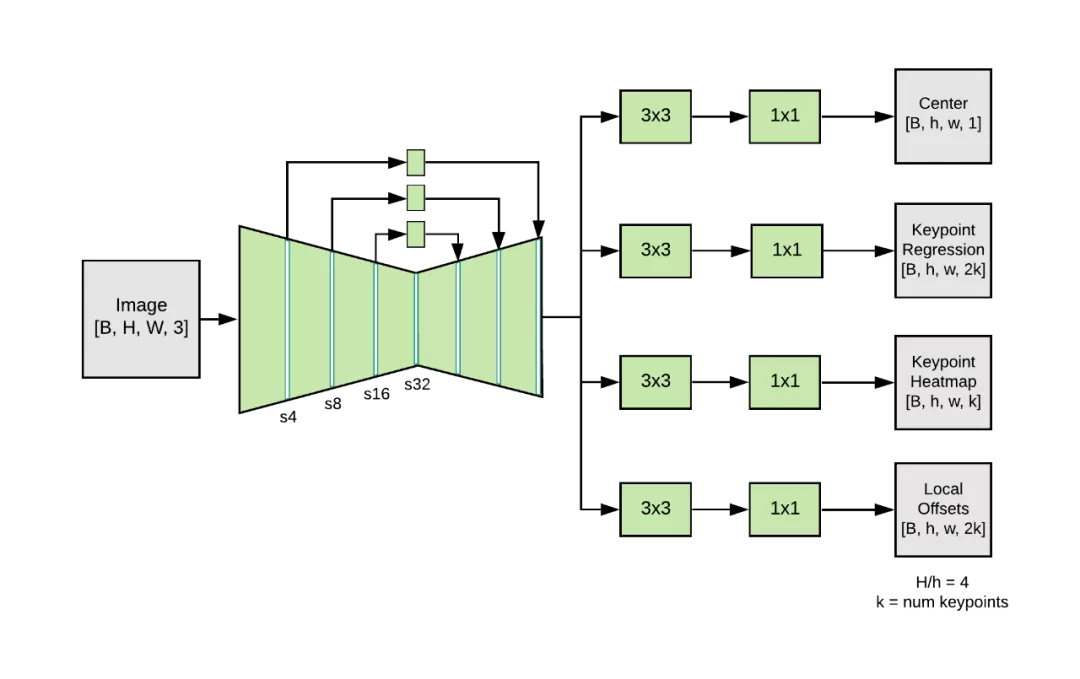

MoveNet 架构

MoveNet 是一种自下而上的估计模型 , 使用热图来准确定位人体关键点 。 该架构由两个组件组成:一个特征提取器和一组预测头 。 预测方案大致遵循 CenterNet , 但变化明显 , 提高了速度和准确率 。 所有的模型都是用 TensorFlow 对象检测 API 进行训练 。

MoveNet 中的特征提取器是带有附加特征金字塔网络 (FPN) 的 MobileNetV2 , 它允许高分辨率(输出跨度为 4) , 此外还提供语义丰富的特征图输出 。 该特征提取器具有四个预测头 , 负责密集地预测:

- 人体中心热图:预测人体实例的几何中心;

- 关键点回归域:预测人体的全部关键点 , 用于将关键点分组到实例中;

- 人体关键点热图:预测所有关键点的位置 , 不依赖于人体实例;

- 2D 每关键点偏移域:预测从每个输出特征图像素到每个关键点的精确子像素位置的局部偏移量 。

文章图片

MoveNet 架构图

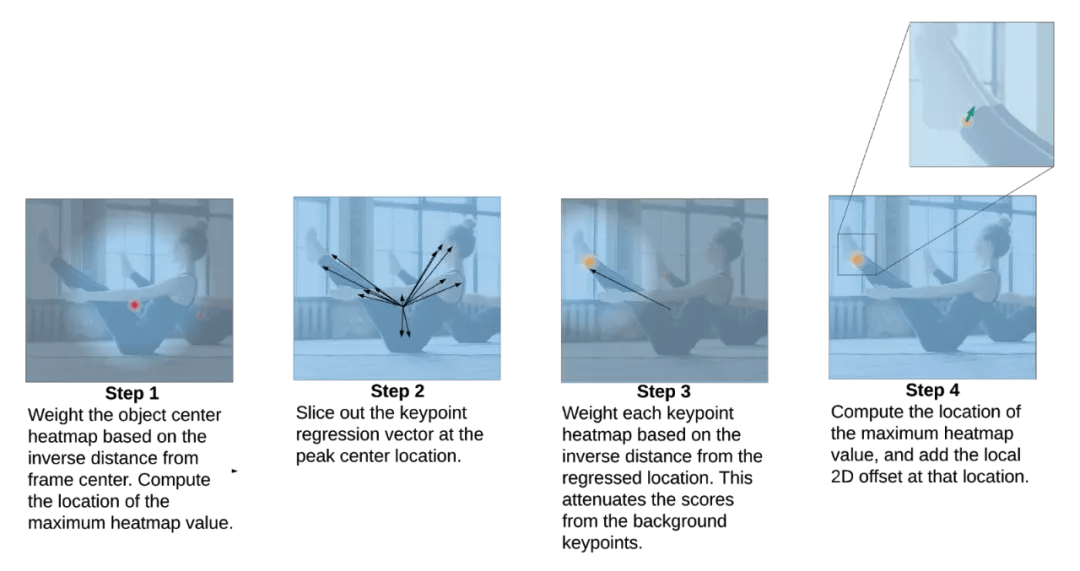

MoveNet 模型分四步来完成预测 , 过程如下图所示:

文章图片

以下是关于 MoveNet 模型的更多参考资料:

- TF Hub 运行:http://tensorflow.google.cn/hub

- Lightning:https://hub.tensorflow.google.cn/google/tfjs-model/movenet/singlepose/lightning/3

- Thunder:https://hub.tensorflow.google.cn/google/tfjs-model/movenet/singlepose/thunder/3

- 广东|广东医生牵头国内首发!《细胞自噬与肾脏疾病研究中国专家共识》发布

- 玩家|《全面战争:战锤3》前瞻试玩&采访:加入震旦的原因是好人太少

- 末世|《消逝的光芒2:人与仁之战》试玩报告:穿梭在末世之间

- 观舌知健康|【青岛六医?健康在线】节目预告 | 健康在线

- 功能|牌佬竟在我身边!《游戏王:Master Duel》登Steam玩家在线榜单

- 心理卫生服务|上海市心理卫生服务行业协会网站启用,市民可在线查询有资质的心理服务机构

- 微创外科|21万人次在线观摩!湖南省第二人民医院微创外科手术直播获赞

- 战斗|《穿越火线:幽灵计划》试玩测评:特色鲜明的沉浸式战斗

- Demo|《解忧咖啡馆2》推出试玩Demo 冲调咖啡互诉衷肠

- 薛海滨|临沂·疾控在线⑦:安全生活,临沂疾控送你“日常消毒攻略”