训练时间和参数量百倍降低,直接使用标签进行预测,性能超GNN

选自arXiv

作者:Qian Huang等

机器之心编译

机器之心编辑部

将传统标签传播方法与简单模型相结合即在某些数据集上超过了当前最优 GNN 的性能 , 这是康奈尔大学与 Facebook 联合提出的一项研究 。 这种新方法不仅能媲美当前 SOTA GNN 的性能 , 而且参数量也少得多 , 运行时更是快了几个数量级 。

图神经网络(GNN)是图学习方面的主要技术 。 但是我们对 GNN 成功的奥秘以及它们对于优秀性能是否必然知之甚少 。 近日 , 来自康奈尔大学和 Facebook 的一项研究提出了一种新方法 , 在很多标准直推式节点分类(transductive node classification)基准上 , 该方法超过或媲美当前最优 GNN 的性能 。

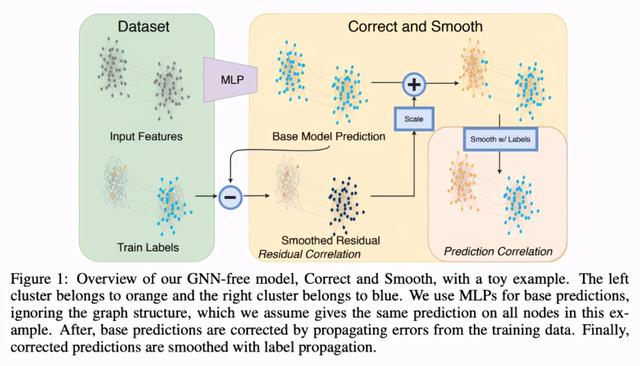

这一方法将忽略图结构的浅层模型与两项简单的后处理步骤相结合 , 后处理步利用标签结构中的关联性:(i) 「误差关联」:在训练数据中传播残差以纠正测试数据中的误差;(ii) 「预测关联」:平滑测试数据上的预测结果 。 研究人员将这一步骤称作 Correct and Smooth (C --tt-darkmode-color: #A3A3A3;">该方法在多个基准上超过或接近当前最优 GNN 的性能 , 而其参数量比后者小得多 , 运行时也快了几个数量级 。 例如 , 该方法在 OGB-Products 的性能超过 SOTA GNN , 而其参数量是后者的 1/137 , 训练时间是后者的 1/100 。 该方法的性能表明 , 直接将标签信息纳入学习算法可以轻松实现显著的性能提升 。 这一方法还可以融入到大型 GNN 模型中 。

论文地址:

GitHub 地址:

图神经网络的缺陷

继神经网络在计算机视觉和自然语言处理领域的巨大成功之后 , 图神经网络被用来进行关系数据的预测 。 这些模型取得了很大进展 , 如 Open Graph Benchmark 。 新型 GNN 架构的许多设计思想是从语言模型(如注意力)或视觉模型(如深度卷积神经网络)中的新架构改编而来 。 但是 , 随着这些模型越来越复杂 , 理解其性能收益成为重要挑战 , 并且将这些模型扩展到大型数据集的难度有所增加 。

新方法:标签信息 + 简单模型

而这篇论文研究了结合更简单的模型能够达到怎样的性能 , 并重点了解在图学习特别是在直推式节点分类中 , 有哪些提高性能的机会 。

研究者提出了一个简单的 pipeline(参见图 1) , 它包含 3 个主要部分:

基础预测(base prediction) , 使用忽略图结构(如 MLP 或线性模型)的节点特征完成;

校正步骤 , 这一步将训练数据的不确定性传播到整个图上 , 以校正基础预测;

【训练时间和参数量百倍降低,直接使用标签进行预测,性能超GNN】平滑图预测结果 。

步骤 2 和 3 只是后处理步骤 , 它们使用经典方法进行基于图的半监督学习 , 即标签传播 。 文章插图

文章插图

通过对这些经典 idea 进行改进和新的部署 , 该研究在多个节点分类任务上实现了 SOTA 性能 , 超过大型 GNN 模型 。 在该框架中 , 图结构不用于学习参数 , 而是用作后处理机制 。 这种简单性使模型参数和训练时间减少了几个数量级 , 并且可以轻松扩展到大型图中 。 此外 , 该方法还可以与 SOTA GNN 结合 , 实现一定程度的性能提升 。

该方法性能提升的主要来源是直接使用标签进行预测 。 这并不是一个新想法 , 但很少用于 GNN 。 该研究发现 , 即使是简单的标签传播(忽略特征)也能在许多基准测试中取得出色的效果 。 这为结合以下两种预测能力来源提供了动力:一个来源于节点特征(忽略图结构) , 另一个来源于在预测中直接使用已知标签 。

具体而言 , 该方法首先使用一个基于节点特征的基础预测器 , 它不依赖于任何图学习 。 然后 , 执行两种类型的标签传播 (LP):一种通过建模相关误差来校正基础预测;一种用来平滑最终预测 。 研究人员将这两种方法的结合称作 Correct and Smooth(C --tt-darkmode-color: #A3A3A3;">该研究还利用两种 LP 和节点特征的优势 , 将这些互补信号结合起来可以获得优秀的预测结果 。

实验

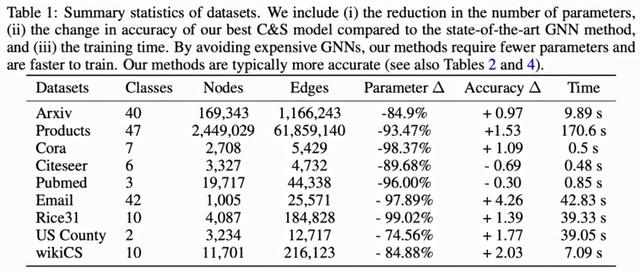

为了验证该方法的有效性 , 研究者使用了 Arxiv、Products、Cora、Citeseer、Pubmed、Email、Rice31、US County 和 wikiCS 九个数据集 。 文章插图

文章插图

节点分类的初步结果

下表 2 给出了相关实验结果 , 研究者得出了以下几点重要发现 。 首先 , 利用本文提出的 C --tt-darkmode-color: #A3A3A3;">使用更多标签进一步提升性能

下表 4 展示了相关结果 , 强调了两点重要发现 。 其一 , 对于想要在很多数据集上实现良好性能的直推式节点分类实验而言 , 实际上并不需要规模大且训练成本高的 GNN 模型;其二 , 结合传统的标签传播方法和简单的基础预测器能够在这些任务上优于图神经网络 。

- 中国|浅谈5G移动通信技术的前世和今生

- 芯片|华米GTS2mini和红米手表哪个好 参数功能配置对比

- 桌面|日常使用的软件及网站分享 篇一:几个动态壁纸软件和静态壁纸网站:助你美化你的桌面

- 二维码|村网通?澳大利亚一州推出疫情追踪二维码 还考虑采用人脸识别和地理定位

- 不到|苹果赚了多少?iPhone12成本不到2500元,华为和小米的利润呢?

- 机器人|网络里面的假消息忽悠了非常多的小喷子和小机器人

- 华为|骁龙870和骁龙855区别都是7nm芯片吗 性能对比评测

- 花15.5亿元与中粮包装握手言和 加多宝离上市又进一步?|15楼财经 | 清远加多宝

- 和谐|人民日报海外版今日聚焦云南西双版纳 看科技如何助力人象和谐

- 机器人|外骨骼康复训练机器人助力下肢运动功能障碍患者康复训练