AI研习丨专题:人工智能系统自身的攻防对抗( 二 )

1.针对输入数据的防御技术

因为很多恶意攻击者利用输入数据来对人工智能系统进行攻击 , 获取模型的信息或者破坏模型的功能 , 针对输入数据的防御技术应运而生 。 为了防御恶意攻击者利用输入数据对人工智能进行的攻击 , 现在已经出现了很多不同类型的防御技术 。

(1)对抗训练

对抗训练是指可以直接在对抗性样本的基础上重新训练模型 , 直到模型学会正确地对它们进行分类 。 这可以使网络对测试集中的对抗性样本具有鲁棒性 , 并且提高网络的整体泛化能力 。 这种方法是简单并且有效的 , 但是 , 因为对抗训练只能有效对抗再训练阶段使用的特定对抗性样本生成算法 , 所以并不能完全解决问题 。

此外 , 对抗性训练的方法想要在大规模模型(例如ImageNet模型)上使用是比较困难的 , 因为重新训练的成本较高 。

(2)输入变换输入变换的主要思想是对输入数据进行预处理或转换(例如图像裁剪、重新缩放、比特深度 缩减和JPEG压缩等)从而消除对抗扰动 , 然后将转换后的图像输入一个未修改的分类器 。 这种变换方法通常不会改变神经网络的结构 。

输入变换很容易被白盒攻击规避 , 因为攻击者可以相应地修改攻击算法 , 在对抗性样本的生成期间考虑系统会进行的变换操作;而在黑盒攻击中 , 它可以提供良好的保护 。 但是 , 输入变换不能消除输入数据中的对抗扰动 , 只能降低攻击成功率 。

(3)梯度屏蔽

梯度屏蔽是指模型所有者希望通过阻止攻击者访问模型的有用梯度信息的方法来防御攻击 。 正如之前所提到的 , 对抗性样本的构造主要基于目标模型的梯度信息 , 如果没有有用的梯度信息 , 攻击者很难生成有效攻击的对抗性样本 。 例如 , 随机化方法在分类网络的开始添加随机调整大小层和随机填充层屏蔽梯度信息 。 随机调整大小是指将输入图像的大小调整为随机大小 , 随机填充 是指以随机方式在输入图像周围填充零 。 然而 , 梯度屏蔽通常不能有效地防御黑盒攻击 , 因为对抗性样本的可转移性 , 攻击者可以在易于攻击的模型上运行其的攻击算法 , 并将这些对抗性样本转移到难以攻击的模型 。

(4)检测与拒绝

检测与拒绝的主要思想是系统由原始分类器和检测器组成 。 检测器可以检测到对抗性样本或者恶意用户 , 然后拒绝其输入或者访问 , 从而保护分类模型 。 例如 , Lu等提出了一个SafetyNet模型 , SafetyNet由传统的分类器(VGG19或ResNet)和对抗样本检测器(RBFSVM)组成 。 RBFSVM查看原始分类器中后面层的内部状态 ,检测对抗性样本 , 如果检测器声明样本是对抗性的 , 那么样本将被拒绝 。

2.针对模型的防御技术

针对模型的防御技术关注的是提升模型自身抵抗攻击的能力 。 在如何提高人工智能系统的鲁棒性方面已经有了一些研究 , 主要可以分为两类 。 一类是针对模型本身进行改进 , 例如Wang和Ye等通过实验讨论了剪枝对某些DNN鲁棒性的影响;而清华大学最新的研究表明 , 适当高的模型稀疏性意味着非线性神经网络具有更好的鲁棒性 , 而过度稀疏的模型则更难以抵抗对抗性样本 。 另 一类是结合其他安全技术来提升人工智能系统的防御能力 , 如Abadi等在差异隐私框架内学习和精确分析隐私成本;Huang等提出具有差分隐私的分布式机器学习 , 保证隐私的同时在通用目标函数下实现更高的效用 。

结束语

随着人工智能技术的飞速发展和广泛应用 , 为了牟利出现的恶意攻击者越来越多 , 人工智能系统的攻防对抗已经成为一个热点问题 , 越来越多的研究者已经在这方面做出了许多成果 。 除了人工智能系统自身的攻防对抗 , 还有许多研究利用人工智能技术来加强传统系统的攻防对抗 。 为了促进人工智能的健康持续发展 , 人工智能系统的安全必须受到重视 。

(参考文献略)

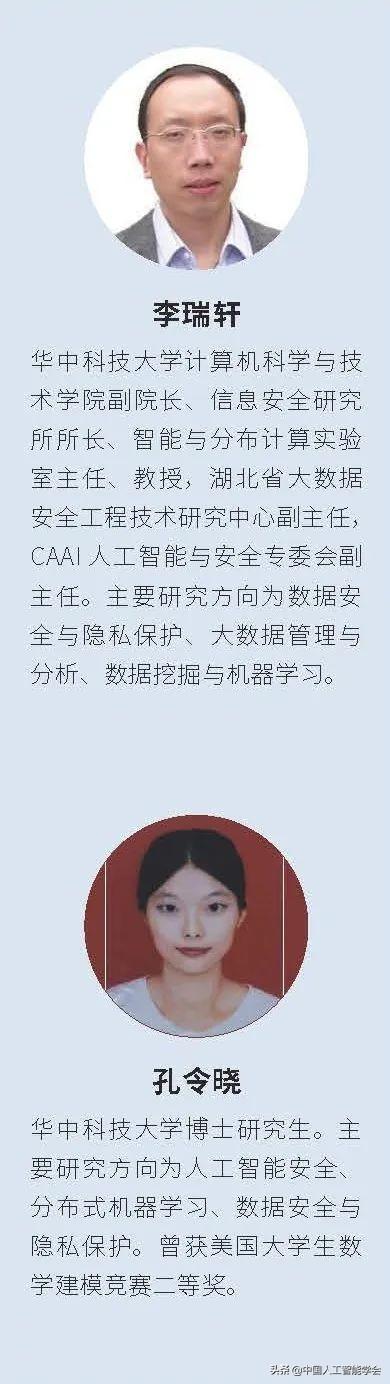

作者简介 文章插图

文章插图

选自《中国人工智能学会通讯》

2020年 第10卷 第4期 人工智能与安全专题

- 出海|出海日报丨短视频生产服务商小影科技完成近4亿元 C 轮融资;华为成为俄罗斯在线出售智能手机的第一品牌

- 正确|新昌消防丨听说,这才是微信新表情的正确打开方式

- 协议|喜讯丨热烈祝贺众科联与顺笑拍、喜到家签订合作协议

- 茶颜悦色|科技神回复丨QQ可以设置ID了,网友:逐渐“微信化”?

- 公众|66兔家说防控丨公众接收快递安全提醒

- 耽误|被阿里耽误的虾米的一生

- 改版|产品观察丨手淘又又又改版了,“逛逛”不买也可以

- 中国|相对论Vol.48丨一个“歪果仁”,为什么要在海外电商平台直播带中国货

- 无人车|市场要闻丨京东公布无人驾驶专利,无人配送暗战打响?

- 美国|北美观察丨实体零售惨淡全靠网购 美国小企业持续倒闭