Glance and Focus: 通用、高效的神经网络自适应推理框架( 三 )

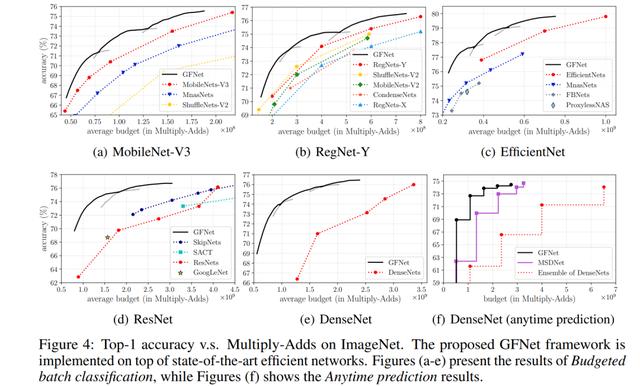

可以看出 , GFNet明显地提升了包括MobileNetV3、RegNet和EfficientNet在内的最新网络结构的推理效率 , 同等精度下 , 计算开销减小达30-40%以上 , 对于ResNet/DenseNet的增幅可达3倍甚至更高;

同等计算开销下 , 对MobileNetV3提点2%左右 , 对ResNet/DenseNet达5-10%以上 。

文章插图

文章插图图8 GFNet基于不同CNN的实验结果(Accuracy v.s. Multiply-Adds)

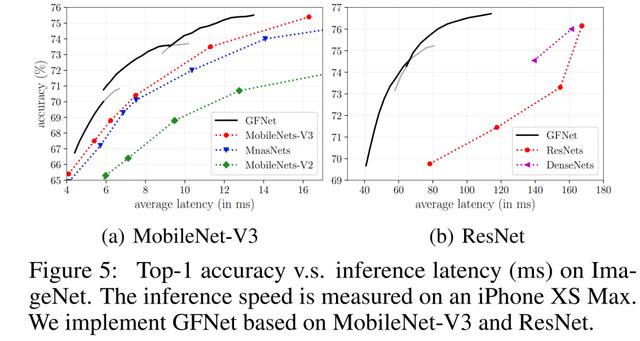

GFNet的另一个显著优势是 , 由于其没有更改CNN的具体结构 , 其可以方便地在移动端或边缘设备上使用现有的工具部署 , 且享有和理论结果几乎等同的实际加速比 。

下图为我们在一台iPhone XS Max(就是我的手机)上基于TensorFlow Lite的测试结果:

文章插图

文章插图图9 GFNet在一台iPhone XS Max上的实际测试结果(Accuracy v.s. Latency)

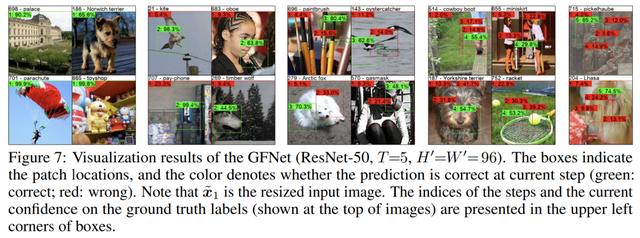

下面是GFNet的一些可视化结果 , 可以从中看出 , 对于比较简单的样本 , GFNet可以仅在Glance阶段或Focus阶段的第一步以很高的confidence得到正确的结果 , 对于较为复杂的样本 , 则实现了以不断关注关键区域的形式逐步提升confidence 。

文章插图

文章插图图10 GFNet的可视化结果

6 结语

最后总结一下 , 其实我本人是非常喜欢这项工作的 , 因为它非常的自然、通用、有效 。

一方面它很好的模拟了生物(或者说人)识别一张图片的过程 , 人眼对图像数据的认知事实上也是一个先扫视得出一些直觉信息、再逐渐关注关键区域的过程 。

另一方面GFNet的实际效果也非常显著 , 且能在目前最佳的一些模型上进一步提升理论计算效率 , 并加快实测速度 。

欢迎大家follow我们的工作~ 。

本文首发于知乎:

参考链接:[1]

[2]

[3]

[4]

[5]

[6]

[赠书福利]

在10月19日头条《专访吴军:未来10年 , AI的发展方向是应用 , 不会出现重大的理论突破》留言区留言 , 谈一谈吴军博士对你的启示 , 或你对信息技术发展的理解 。

AI 科技评论将会在留言区选出 10 名读者 , 每人送出《信息传》一本 。

活动规则:

1. 在留言区留言 , 留言点赞最高的前 10 位读者将获得赠书 。 获得赠书的读者请联系 AI 科技评论客服(aitechreview) 。

2. 留言内容会有筛选 , 例如“选我上去”等内容将不会被筛选 , 亦不会中奖 。

3. 本活动时间为2020年10月19日 - 2020年10月23日(23:00) , 活动推送内仅允许中奖一次 。

NeurIPS 2020论文接收列表已出 , 欢迎大家投稿让更多的人了解你们的工作~

文章插图

文章插图 文章插图

文章插图- 合并|Andre Cronje主导批量「合并」DeFi项目,是好事情吗?

- Android|索尼Android 11更新时间表公布 最早本月开始

- Python中文速查表-Pandas 基础

- Pandas教程

- POCO F2 Pro获Android 11稳定版更新

- 随机森林(Random Forest)算法原理

- Python数据处理,pandas 统计连续停车时长

- 不常见的Pandas小窍门:我打赌一定有你不知道的

- 详解command设计模式,解耦操作和回滚

- 装机必备!解压缩神器Bandizip中文免费版|电脑软件