算力至上?四大AI芯片大对决( 三 )

文章插图

文章插图

但是 , 研发这样的芯片有着极高的成本和风险 。 与软件开发不同 , 芯片开发全程都需要大量的人力物力投入 , 开发周期往往长达数年 , 而且失败的风险极大 。 放眼全球 , 同时拥有雄厚的资金实力和技术储备以进行这类研发的公司 , 大概用两只手就能数的出来 。 也就是说 , 这种方案对于大多数公司而言并可能没有直接的借鉴意义 。

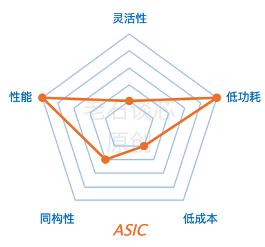

此外呢 , AI专用芯片的灵活性往往比较低 。 顾名思义 , 包括谷歌TPU在内的AI专用芯片 , 通常是针对某种特定应用而设计开发 , 因此它可能很难适用于其他的应用 。 在使用成本的角度 , 如果要采用基于ASIC的方案 , 就需要这类目标应用有足够的使用量 , 以分摊高昂的研发费用 。 同时 , 这类应用需要足够稳定 , 避免核心的算法和协议不断变化 。 而这对于很多AI应用来说是不现实的 。

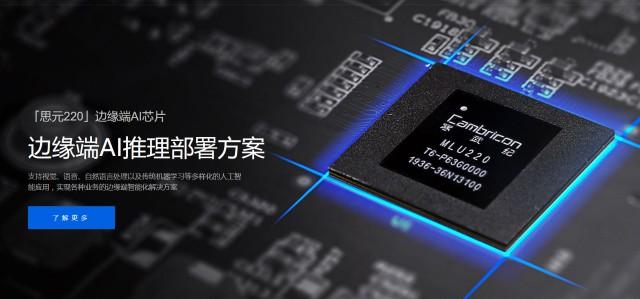

值得一提的是 , 我国在人工智能专用芯片领域涌现出来了一波优秀的公司 , 比如寒武纪、地平线 , 还有之前被赛灵思收购的深鉴科技等等 。 受篇幅限制 , 关于这些公司的具体产品和技术 , 这里就不再展开了 。 文章插图

文章插图

FPGA

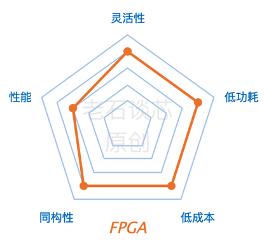

最后再来说一下FPGA 。 我个人认为 , FPGA能够在这些性能指标中达到比较理想的平衡 。 当然了 , 我目前的职业就和FPGA紧密相关 , 所以这个结论有屁股决定脑袋之嫌 , 谨供大家借鉴 。 文章插图

文章插图

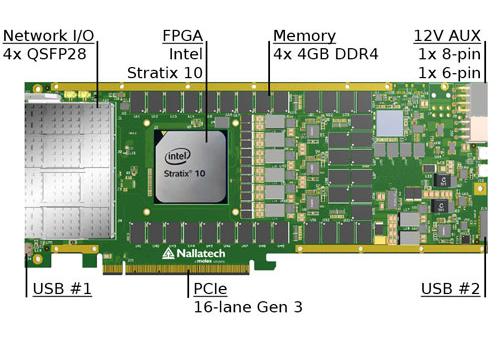

在性能方面 , FPGA可以实现定制化的硬件流水线 , 并且可以在硬件层面进行大规模的并行运算 , 而且有着很高的吞吐量 。

FPGA最主要的特点其实是它的灵活性 , 它可以很好的应对包括计算密集型和通信密集型在内的各类应用 。 此外 , FPGA有着动态可编程、部分可编程的特点 , 也就是说 , FPGA可以在同一时刻处理多个应用 , 也可以在不同时刻处理不同的应用 。

在数据中心里 , 目前FPGA通常以加速卡的形式配合现有的CPU进行大规模部署 。 FPGA的功耗通常为几十瓦 , 对额外的供电和散热等环节没有特殊要求 , 因此可以兼容数据中心的现有硬件基础设施 。

在衡量AI芯片的时候 , 我们也经常使用性能功耗比这个标准 。 也就是说 , 即使某种芯片的性能非常高 , 但是功耗也非常高的话 , 那么这个芯片的性能功耗比就很低 。 这也是FPGA相比GPU更有优势的地方 。 文章插图

文章插图

在开发成本方面 , FPGA的一次性成本其实远低于ASIC , 因为FPGA在制造出来之后 , 可以通过重复编程来改变它的逻辑功能 。 而专用芯片一旦流片完成就不能修改了 , 但是每次流片都会耗资巨大 。 这也是为什么包括深鉴在内的很多AI芯片的初创企业 , 都使用FPGA作为实现平台的原因 。

所以说 , 相比其他硬件加速单元而言 , FPGA在性能、灵活性、同构性、成本和功耗五个方面达到了比较理想的平衡 , 这也是微软最终选用FPGA , 并在数据中心里进行大规模部署的主要原因 , 有兴趣的朋友 , 可以看之前的文章《FPGA在微软数据中心的前世今生》 。 文章插图

文章插图

结语

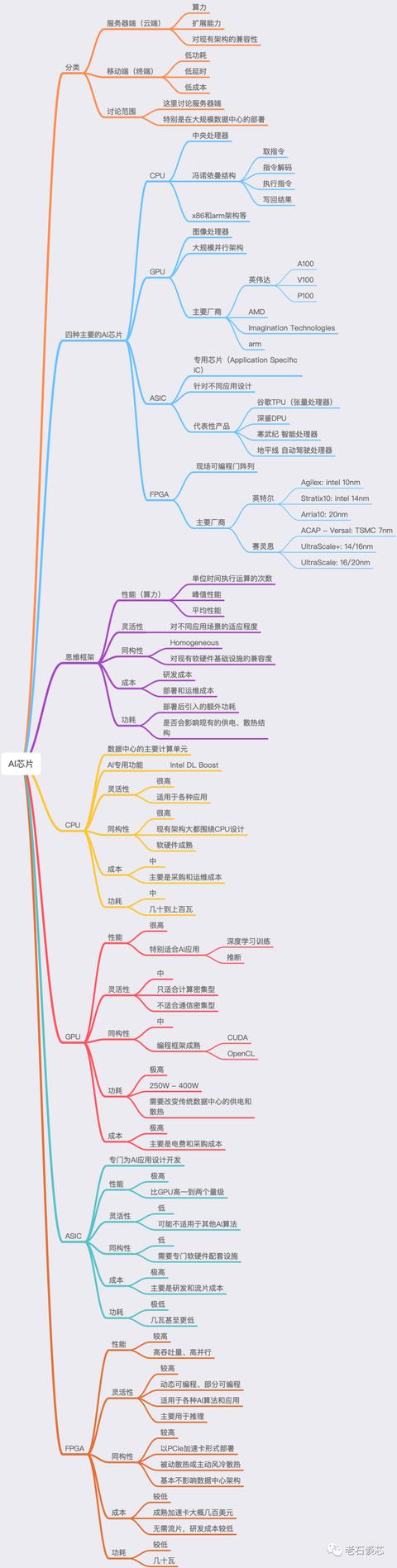

在这篇文章里 , 我们讨论了人工智能芯片的主要分类 , 比如按应用场景 , 可以分成服务器端和移动端两类 。 我们介绍了四种可以用来执行人工智能应用的芯片 , 分别是CPU、GPU、ASIC和FPGA 。 我们还根据一个思维框架 , 从性能、灵活性、同构性、功耗、成本五个方面 , 分别衡量了这四种芯片的优缺点 。

事实上 , 对于这个问题并没有一个唯一的答案 。 我们只有根据特定的“Context” , 也就是具体情况具体分析 , 才能找到最适用于某个应用的AI芯片 。 而这种理性的思维方式 , 其实也适用于我们日常工作和生活的各种事情 , 这也是本文想要传达的最重要的内容 。 文章插图

文章插图

【算力至上?四大AI芯片大对决】(注:本文仅代表作者个人观点 , 与任职单位无关 。 ) 文章插图

文章插图 文章插图

文章插图

- 痛点|首个OTA智能社区诞生 解决行业四大痛点

- 至上|男人的工具箱:五金工具跟着我来买,实用至上,绝不吃灰

- 好消息!三大运营商变成四大运营商,只因未来手机流量相当于电力

- 曾是国产四大品牌之一的联想为何会没落?原来是公司内部出了问题

- 四大银行正式宣布!支付宝、微信只能接受现实,用户:终于等到了

- 话费要降了?第四大运营商已成立,对老百姓的影响可不少

- 四大银行正式宣布!微信支付宝或将被淘汰,马云也无可奈何?

- 生态圈|储雪俭:四大举措重塑供应链金融生态圈

- 者最多|盘点NFT产品四大“最”

- 广电宽带初体验,四大运营商角力,老百姓在意的什么?