文章图片

总结

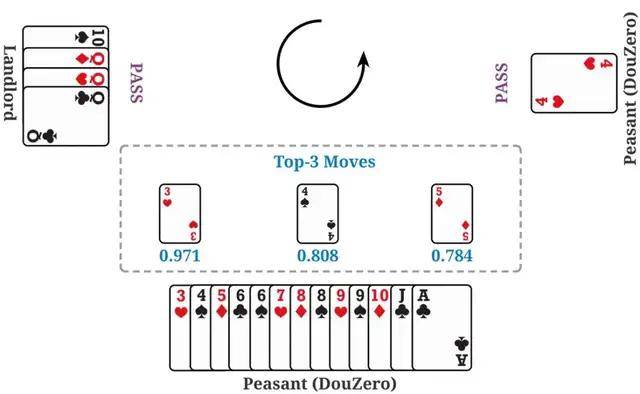

斗零的成功表明简单的蒙特卡罗算法经过一些加强(神经网络和动作编码)就可以在复杂的斗地主环境上有着非常好的效果 。 作者希望这个结果能启发未来强化学习的研究 , 特别是在稀疏奖励、复杂动作空间的任务中 。 蒙特卡罗算法在强化学习领域一直不受重视 , 作者也希望斗零的成功能启发其他研究者对蒙特卡罗方法做更深入的研究 , 更好地理解在什么情况下蒙特卡罗方法适用 , 什么情况下不适用 。

为推动后续研究 , 作者开源了斗地主的模拟环境和所有的训练代码 。 值得一提的是 , 斗零可以在普通的服务器上训练 , 并不需要云计算的支持 。 作者同时开源了在线演示平台和分析平台 , 以帮助研究者和斗地主爱好者更好地理解和分析 AI 的出牌行为 。 鉴于当前的算法极其简单 , 作者认为未来还有很大的改进空间 , 比如引入经验回放机制来提高效率、显性建模农民之间的合作关系等等 。 作者也希望未来能将斗零的技术应用到其他扑克游戏以及更加复杂的问题中 。

研发团队介绍:这项工作是由 Texas A&M University 的 DATA 实验室和快手 AI 平台部的游戏 AI 团队合作而成 。 DATA 实验室主要从事数据挖掘和机器学习算法等方面的研究 , 以更好地从大规模、网络化、动态和稀疏数据中发现可操作的模式 。 快手游戏 AI 团队 , 主要依托在最先进的机器学习技术 , 致力于服务游戏研发 , 推广 , 运营等各个环节 。

参考文献:

[1] Lerer, Adam, et al. "Improving policies via search in cooperative partially observable games." Proceedings of the AAAI Conference on Artificial Intelligence. Vol. 34. No. 05. 2020.

[2] Zha, Daochen, et al. "RLCard: A Platform for Reinforcement Learning in Card Games." IJCAI. 2020.

[3] You, Yang, et al. "Combinational Q-Learning for Dou Di Zhu." arXiv preprint arXiv:1901.08925 (2019).

[4] Sutton, Richard S., and Andrew G. Barto. Reinforcement learning: An introduction. MIT press, 2018.

[5] Jiang, Qiqi, et al. "DeltaDou: Expert-level Doudizhu AI through Self-play." IJCAI. 2019.

- 电竞|因和平精英赛事,快手再获电竞大奖,年底还要搞大动作?

- 平台|快手游戏荣获2021年度电竞赛事合作平台奖,深耕国际赛事共建电竞生态

- 玩法|快手官宣春节活动瓜分 22 亿红包,19 日晚 8 点上线

- 运送员|科学精准防疫微镜头丨样本运送员邵元亮——“残缺”快手的120次“摆渡”

- 经营|快手游戏业务寻突破,海外FPS能否助其打开局面

- 投资|魂世界获快手投资,曾研发流水数亿的模拟经营游戏

- 王姐|甲状腺癌,我需要尽快手术

- 焯水|冬季,宁可不吃肉也要吃这菜,鲜美营养又快手,应季而食,身体棒

- 广君|这款红了13年的游戏,让我看到快手上更多元的游戏文化

- 快手极速版邀请一个新人能赚多少钱?