文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

丰色 发自 凹非寺量子位 报道 | 公众号 QbitAI

有这样一个模型 。

它可以做到一句话生成视频:

【女娲|一个模型通杀8大视觉任务,一句话生成图像视频、P图视频处理都行】不仅零样本就能搞定 , 性能还直达SOTA 。

它的名字 , 叫“NüWA”(女娲) 。

“女娲女娲 , 神通广大” , 正如其名 , 一句话生成视频只是这个模型的技能之一 。

除此之外 , 一句话生成图片 , 草图生成图像、视频 , 图像补全 , 视频预测 , 图像编辑、视频编辑——

一共八种视觉任务 , 它其实全部都能搞定 。

完全是一位不折不扣的“全能型选手” 。

它 , 就是由微软亚研院和北大联合打造的一个多模态预训练模型 , 在首届微软峰会上亮相 。

目前 , 在推特上已“小有热度” 。

八项全能“女娲” , 单拎出来也不差

所以这个全能型选手究竟表现如何?

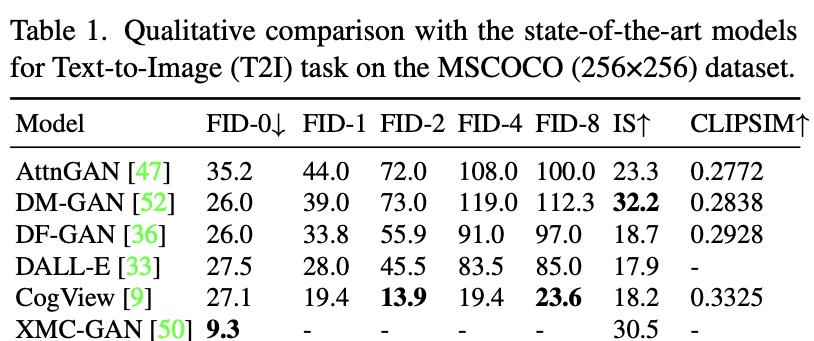

直接与SOTA模型对比 , 来看看“她”在各项任务上的表现 。

在文本生成图像中 , 不得不说 , 即使“女娲”的FID-0得分不及XMC-GAN , 但在实际效果中 , “女娲”生成的图肉眼可见的更好 , 清晰又逼真 。

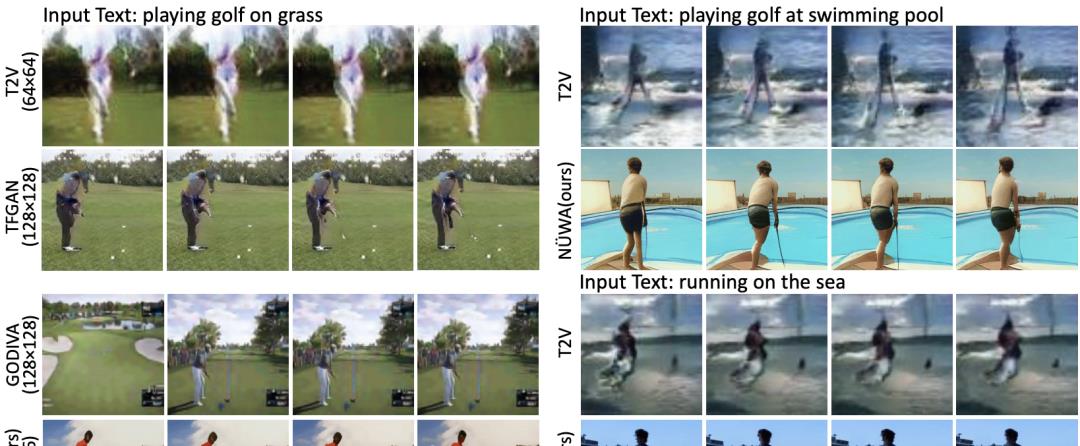

文本到视频中 , “女娲”每一项指标都获得了第一名 , 从逐帧图片来看 , 差距很明显 。

在视频预测中 , 所有模型使用64x64的分辨率 , Cond.代表供预测的帧数 。

尽管只有1帧 , “女娲”也将FVD得分从94±2降到86.9 。

草图转图像时 , 与SOTA模型相比 , “女娲”生成的卡车都更逼真 。

而在零样本的图像补全任务中 , “女娲”拥有更丰富的“想象力” 。

在零样本的图像编辑任务中 , “女娲”明显比SOTA模型的“P图”能力更强 。

并且 , 它的另一个优势是推理速度 , 几乎50秒就可以生成一个图像;而Paint By Word在推理过程中需要额外的训练 , 大约需要300秒才能收敛 。

而草图生成视频以及文本引导的视频编辑任务 , 是本次研究首次提出 , 目前还没有可比对象 。

直接上效果:

看 , 像上面这些仅用色块勾勒轮廓的视频草图 , 经“女娲”之手就能生成相应视频 。

而输入一段潜水视频 , “女娲”也能在文本指导下让潜水员浮出水面、继续下潜 , 甚至“游”到天上 。

可以说 , “女娲”不仅技能多 , 哪个单项拿出来也完全不赖 。

如何实现?

这样一个无论操作对象是图像还是视频 , 无论是合成新的、还是在已有素材上改造都能做到做好的“女娲” , 是如何被打造出来的呢?

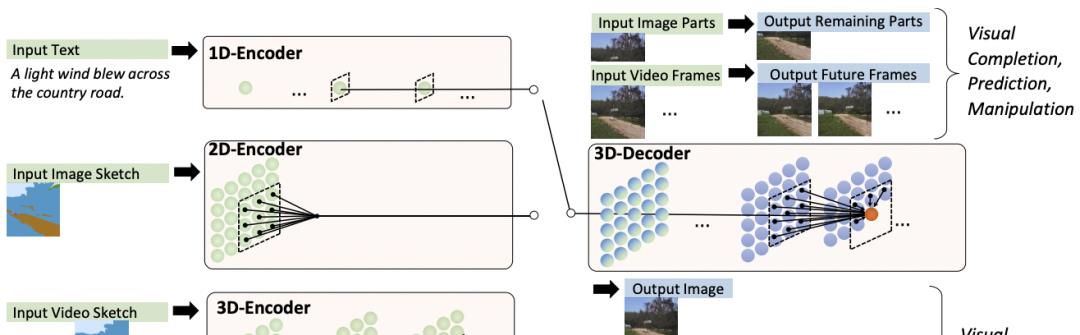

其实不难 , 把文字、图像、视频分别看做一维、二维、三维数据 , 分别对应3个以它们为输入的编码器 。

另外预训练好一个处理图像与视频数据的3D解码器 。

两者配合就获得了以上各种能力 。

其中 , 对于图像补全、视频预测、图像视频编辑任务 , 输入的部分图像或视频直接馈送给解码器 。

而编码解码器都是基于一个3D Nearby的自注意力机制(3DNA)建立的 , 该机制可以同时考虑空间和时间轴的上局部特性 , 定义如下:

W表示可学习的权重 , X和C分别代表文本、图像、视频数据的3D表示:

其中 , h和w表示空间轴上的token数 , s表时间轴上的token数(文本默认为1) , d表示每个token的维数 。

如果C=X , 3DNA表示对目标X的自注意;如果C≠X , 3DNA表示对在条件C下目标X的交叉注意 。

- 霍金|霍金留下三个预言,每一个都事关人类安危,第一个已经开始应验

- 三星|德媒:中国或许将成为下一个全球创新总部!

- 女娲|进化论是西方独有吗,其实中国早有“进化”思想

- 数字货币|你的“花呗”额度降了吗?“借呗”整改后下一个来了,有用户直接被停

- Windows|New Windows 11操作系统壁纸灵感来源,新的视角,一个新的时代

- 奥陌陌|奥陌陌:人类观察到的第一个外星文明迹象?留下了哪些未解之谜?

- 联想|拆解联想电脑,没有任何一个核心零部件是国产的,塑料壳和螺丝是国产的

- 物联网|物联网解决方案的前端开发

- 伏羲女娲图|破译《伏羲女娲图》中蕴藏的宇宙奥秘!

- UFO|詹姆斯韦伯遇到了一个小问题,全面测试导致发射延迟了几天