听说"浙"里正在培育super节能的互联网数据中心

据说 , 最近国网浙江双创中心正在搞大事情?是啥情况?

小e去了解了一下 , 原来是这样:

文章插图

文章插图

我们知道 , 随着计算机和互联网的广泛应用 , 人类产生、创造的数据量呈爆炸式增长 , 我国正式进入了超大规模数据中心(超算)时代 。 大数据时代为人们的生产生活带来了前所未有的便利 , 而这一切的实现都要依赖于互联网数据中心(IDC)的高效稳定运行 。

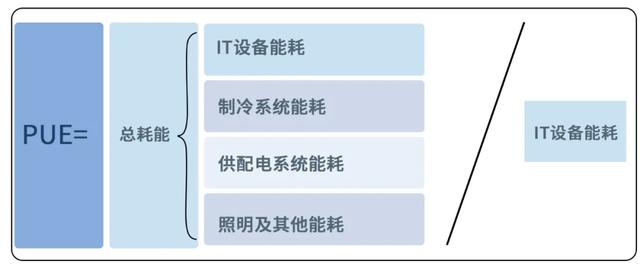

数据中心的耗电量惊人 。 据统计 , 2020年1月至5月 , 杭州全部53座数据中心“吃”掉了总计5.97亿千瓦时电量 。 这个用电量是什么概念呢?它相当于杭州20万个家庭一整年的用电量 。 这么多的电用在了什么地方呢?PUE(Power Usage Effectiveness)是目前衡量数据中心能效的重要指标 , 其构成显示了数据中心的电能消耗分布(下图所示):

文章插图

文章插图

电能输入数据中心 , 数据中心在输出高品质信息流的同时 , 也产生了大量热能 。 IT设备功率密度急剧攀升 , 热度负荷也节节攀升 , 数据中心的机房散热遭遇了前所未有的挑战 。

怎么给数据中心降温?这是个问题 。

传统数据中心采用空调制冷 , 即所谓风冷 。 在一个PUE约为2的传统风冷数据中心总能耗中 , IT设备能耗占比最高 , 约为50%;其次是制冷系统能耗 , 约占35%;其能耗构成如下图所示:

文章插图

文章插图

在能源供应紧张的背景下 , 高能耗成了制约数据中心发展的瓶颈 。 近年来 , 多项国家政策出台 , 对数据中心的节能水平提出了更新更高的要求 。 如何实现数据中心输入更少的电能 , 输出更多的信息流 , 降低制冷系统能耗 , 同时实现副产热能二次利用成了令人既兴奋又头疼的课题 。

现在它来了:

国网浙江双创中心正在培育新一代浸没式液冷数据中心 , 能使PUE轻松降至1.1以下 , 下面我们来一探庐山真面目:

这款super节能的IDC , 叫做“新一代浸没式液冷数据中心” , 它采用“泡澡”的方式 , 将服务器整个浸没封装在绝缘冷却液机柜中 , 实现余热利用 , 一举两得 。

文章插图

文章插图

Q: 什么?将服务器浸泡在“水”里?

A:no , 我们采用的是一种无毒无害、稳定不挥发、安全闪点高的绝缘冷却液 。

Q: 服务器会不会泡坏?

A:绝缘冷却液对构成服务器的各种材料都具有很好的兼容性 。

Q:IDC正常运行时 , “水”会烧开吗?

A:不会 , 我们采用单相液冷技术 , 不会发生相变 , 这样数据中心不用全密闭 , 运维更加方便 。

Q:那数据中心产生的热量到哪里去了?

A:数据中心产生的热量通过冷却水回收利用 。

Q: 它与传统风冷数据中心相比 , 有什么优点?

A:那简直不要太好 , 三伏天正常运行无需空调制冷 , 数据中心产生的热量可储存于冷却水中 , 实现能量二次利用 , 节省了部署空间 。

再来详细看看几组对比:

风冷噪音 VS 新一代浸没式液冷静音

“浸没式液冷”技术散热不再需要靠风扇 , 所以使用浸没式液冷技术的数据中心将会是静音的数据中心 , 可以避免因服务器等设备风扇产生的噪音过大的问题 。

风冷故障 VS 新一代浸没式液冷无影响

传统的风冷系统会带来空气的流动而产生振动 , 振动会直接影响IT系统的稳定性和寿命 。 但液冷则完全不必担心这个问题 。

这么“冷静”、低耗的数据中心 , 你说香不香?

文章插图

文章插图

- DBUtils工具类,听说你没用过?

- 开启Scrapy爬虫之路!听说你scrapy都不会用?

- 听说生鲜领军企业k8s集群都上云了,鱼会飞了?

- 去"政策指导",以市场引导为主发展新能源汽车,专家说的太对了

- 为什么很多用了几十年的主板也没听说过BIOS的数据坏了的呢?

- 中国5G:用户数远超1.5亿,其中非"真实"用户超五千万

- 视觉|听说电竞酒店很火,而配套上横空出世的海兰S700就更火了

- 5G时代将临!雷布斯整装待发,下一个"十年计划"不远了

- 久等了 它来了!AMD RADEON RX6800XT&6800显卡

- 华为岳坤:智慧城市建设进入深水区,如何避免"中看不中用"?