别止步当下:800G数据中心的发展趋势与挑战

当前 , 100G光学器件正大量涌入市场 , 预计明年也会迎来400G 。 尽管如此 , 东西向数据流量仍在持续增加 , 数据中心面临的压力将有增无减 。

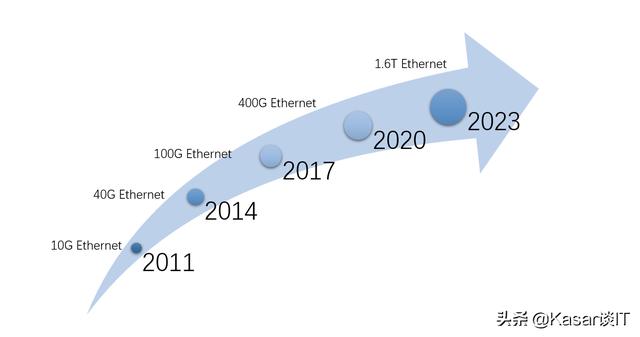

随着大带宽、大容量和低延迟的需求在不断增长 , 推动了网络市场向更快网络速度的迁移 。 因此每一年 , 对于大规模云数据中心的适应和生存能力都是一场考验 。 当前 , 100G接口正大量涌入市场 , 预计今年年底至明年400G将迎来高潮 。 尽管如此 , 东西向的数据流量仍在持续增加 , 数据中心面临的压力将有增无减 。

文章插图

文章插图

寻求平衡数据中心的能力由服务器、交换机和连接因素决定 , 三者相互制约与平衡 , 同时也推动着彼此向着更快、更低成本的方向发展 。 多年来 , 交换技术一直是主要的驱动力 。 随着博通StrataXGS Tomahawk 3的推出 , 数据中心管理人员现在可以将交换和路由速度提高到12.8Tbps , 并将每端口成本降低75% 。 那现在的性能限制因素是CPU吗?其实不然 , 今年年初 , NVIDIA推出了用于服务器的全新Ampere架构芯片 。 事实证明 , 游戏领域使用的处理器非常适合处理人工智能(AI)和机器学习(ML)所需的训练和推理 。 那么限制因素是什么呢?

网络成为瓶颈【别止步当下:800G数据中心的发展趋势与挑战】随着交换机和服务器向着支持400G和800G的方向不断发展 , 保持网络平衡的压力就转移到了物理层 。 2017年批准的IEEE 802.3bs标准为200G和400G以太网铺平了道路 。 有关800G及以上的带宽评估工作 , IEEE最近才刚完成 。 考虑到开发和采用新标准所需的时间 , 进度可能已有所滞后 。 随着行业致力于向着400G到800G , 再到1.6 Tb乃至更高带宽跃进 , 布线和光学OEM也一直在奋力前行 。 以下 , 是我们看到的一些发展趋势 。

交换机在升级首先 , 服务器的配置和布线架构正在不断升级 。 聚合交换机从机架的顶部(TOR)正向中间行(MOR)转移 , 并通过综合布线配线架连接到交换机端口 。 如今 , 若数据中心需要迁移到更高的速度 , 只需简单地替换服务器跳线 , 而无需替换原本更长的交换机到交换机的主干链路 。 采用这种结构化的布线设计 , 也就无需在交换机和服务器之间安装并管理192条有源光缆(Active Optical Cable) 。

光模块外形尺寸变化可插拔光模块的全新设计为网络设计师提供了更多可选的工具 , 其中包括支持400G的QSFP-DD和OSFP 。 两种外形上均具有8倍通道 , 光学器件可提供8个50G PAM4 。 在32端口配置中部署时 , QSFP-DD和OSFP模块可在1RU设备中实现12.8 Tbps 。 OSFP和QSFP-DD尺寸支持当前的400G光模块和下一代800G光模块 。 使用800G光纤 , 交换机将达到每1U 25.6Tbps 。

全新400GBASE标准还有更多的连接器选项可支持400G短距离MMF(多模光纤)模块 。 400GBASE-SR8标准下 , 可使用24芯MPO连接器(适用于传统应用)或单行16芯MPO连接器 。 单行MPO16是早期云规模服务器连接的首选 。 另一种选择是400GBASE-SR4.2 , 它使用具有双向信令的单行MPO12 , 非常适用于交换机到交换机的连接 。 IEEE802.3 400GbaseSR4.2是首个在MMF上利用双向信令的IEEE标准 , 它引入了OM5多模光纤 。 OM5光纤扩展了对BiDi等应用的多波长支持 , 使网络设计人员能够实现比OM4多50%的传输距离 。

但我们的行动足够迅速吗?业界预测 , 未来两年内将需要用到800G光学器件 。 800G可插拔MSA已于2019年9月面世 , 可助力开发新应用 , 包括适用于60至100米跨度的低成本8x100G SR多模模块 。 其目标是提供一种早期低成本800G SR8解决方案 , 使数据中心能够支持低成本服务器应用 。 可插拔式800G将支持更高的交换机基数 , 以及更低的单机架服务器数量 。

同时 , IEEE 802.3db工作组正在研究针对100G/波长的低成本VCSEL解决方案 , 并证明了在OM4 MMF上达到100米的可行性 。 如果成功 , 这项工作就能将服务器连接从机架内DAC转换为MOR/EOR高密度交换机 。 它将提供低成本的光学连接 , 并能够为传统MMF提供更长期的应用支持 。

- 互联网+废品回收,真正的暴利行业!环保为主的当下,暴富很简单

- 201万年薪,华为再迎“天才少年”

- 新版5元人民币即将发行,外观大变样,早看早适应

- 当下那档事|手机配置参数对用户的使用都有哪些影响?你选择对了吗?

- 永不止步IPFS|Filecoin矿工收益减少的原因是什么?三方博弈矿工只能折中前行

- 永不止步IPFS|Web3.0时代,Filecoin未来方向是什么?能否引领分布式存储走向

- 路由器|当下,什么路由器最值得购买? WiFi6对比WiFi5到底有多少提升?

- 全现在|爱优腾表示不服,B站也要做直播带货