深度学习入门之第五章:经典卷积神经网络( 六 )

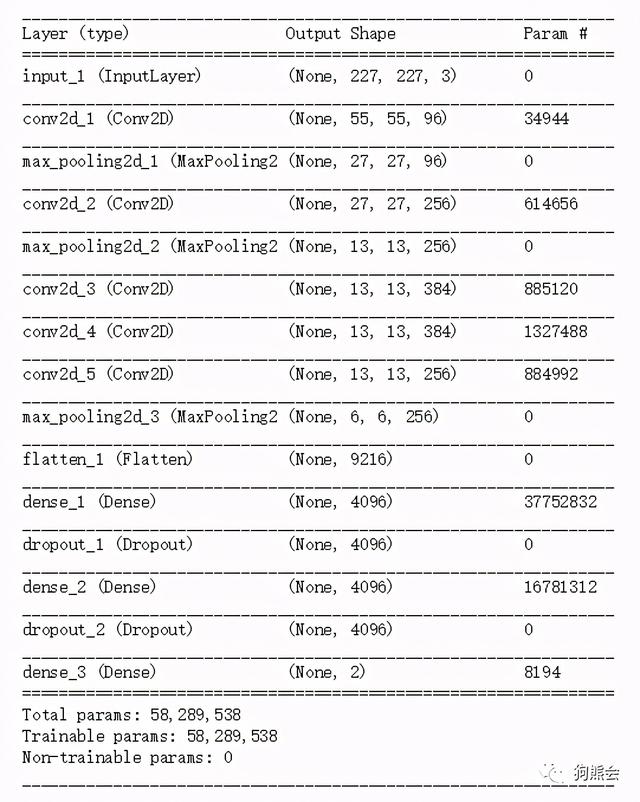

通过model.summary()给出的模型概要表如图5.5所示 。 下面再次复习有关神经网络参数个数的计算 。

(1)第一层卷积核的大小为11×11 , 消耗的参数个数为(11×11×3=1)×96=34944(加1的原因是多一个截距项 , 乘以96是因为总共有96个卷积核) 。

(2)第二层为最大值池化 , 不消耗任何参数 。

(3)该层的输入为第(2)层池化的输出 , 为27×27×96的立体矩阵 , 在这个基础上做规格大小为5×5的卷积 , 消耗的参数个数为(5×5×96+1)×256=614656 。

再之后的参数个数 , 读者可以自行计算并与图5.5中的结果对比 。 这样的练习对于理解神经网络的结构是非常有帮助的 。

文章插图

文章插图

图5.5 AlexNet模型概要表

04

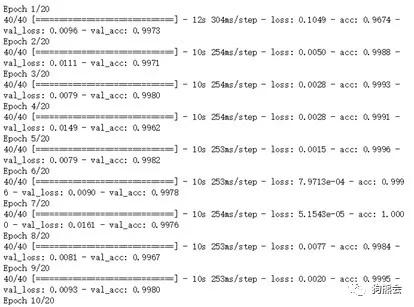

AlexNet编译运行

AlexNet的模型编译设定和LeNet-5类似 , 因为处理的都是分类问题 , 损失函数指定为categorical_crossentropy , 优化方法为Adam(学习速率指定为0.001) , 评价指标为预测精度 。 作为示例 , 进行20个epoch循环 , 从结果可以看到 , 进行第10个epoch时外样本精度已经有99% , 效果非常不错 。 具体如代码示例5-8 。

代码示例5-8:AlexNet模型编译与拟合

1from Keras.optimizers import Adam2model.compile(loss='categorical_crossentropy',optimizer=Adam(lr=0.001),metrics=['accuracy'])3model.fit_generator(train_generator,epochs=20,validation_data=http://kandian.youth.cn/index/validation_generator)输出:

文章插图

文章插图

以上就是今天为大家介绍的两个经典卷积神经网络模型 , 下周我们继续更新其他经典的CNN模型 。 欢迎大家同步收看狗熊会慕课平台的深度学习课程 , 里面有熊大的精彩讲解!

- 系统性学习Node.js(5)—手写 fs 核心方法

- 固态硬盘入门手册,一看就精通的电脑硬件教程

- SpringBoot2.x入门到项目实战课程系列(第二章)

- 无需入耳的蓝牙,南卡骨传导蓝牙耳机深度体验

- 使用半监督学习从研究到产品化的3个教训

- Rust语言学习:Beginning_Rust

- 如何编写JAVA小白第一个程序

- 「OpenCV入门教程」线性滤波方框滤波、均值滤波与高斯滤波

- 不需要负样本对的SOTA的自监督学习方法:BYOL

- Linux培训完能到什么水平,之后还需要学习哪些技术?