一文带你了解基于视觉的机器人抓取自学习( 四 )

文中提出了一种跨模态预测方法 , 用于从触摸预测视觉 , 反之亦可 。 研究人员首先将触觉中的程度、规模、范围和位置信息结合在模型中 。 然后 , 使用数据平衡的方法多样化其结果 。 最后 , 通过考虑时间信息的方法进一步提高准确性 。

研究中的模型基于pix2pix方法 , 是一个用于图像到图像任务的条件GAN框架 。 在任务中 , 生成器接受视觉图像或触觉图像作为输入 , 并生成一个对应的触觉或视觉图像 。 而判别器观察输入的图像和输出的图像 。 在训练中 , 对判别器进行训练 , 以分辨合成图片和真实图片之间的差异 , 而生成器则是用于产生可以欺骗判别器的图片 。 在实验中 , 研究人员使用视觉-触觉图像对训练模型 。 在从触觉还原视觉的任务中 , 输入触觉图像 , 而输出是对应的视觉图像 。 而在视觉预测触觉的任务中 , 则输入和输出对调 。

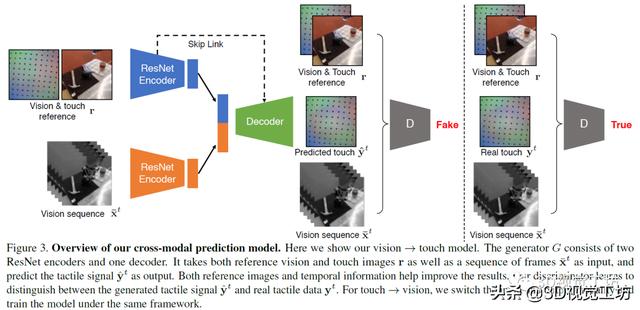

模型使用编码器-解码器架构用于生成任务 。 在编码器上分别使用两个ResNet-18模型用于输入图像(视觉或触觉图像)和参考的视觉-触觉图像 , 将两个编码器的向量合并为一个1024维向量 , 将其输入解码器 。 解码器包括五层标准的卷积神经网络 , 并在编码器和解码器间加入了跨层连接 , 研究中使用的判别器为ConvNets 。 文章插图

文章插图

研究发现 , 实验结果不是很好 , 图片中有严重的视觉伪影 , 并且生成的结果与输入信号不一致 。 为解决上述问题 , 研究人员对基本算法进行修改和完善 。 首先将触觉和视觉参考图像提供给生成器和判别器 , 以便该模型只需要学习为交叉模式变化建模 , 而不是整个信号 。 其次 , 为防止模式崩塌 , 研究人员采取数据重均衡策略帮助生成器生成不同的模式 , 性能更加健壮 。 最后 , 从输入视频的多个相邻帧而不是仅从当前帧中提取信息 , 从而产生时间相干的输出 。

研究人员在一个KUKA机械手臂上放置GelSight传感器 , 机械臂背面的三脚架上安装了一个网络摄像头 , 以捕捉机械臂触摸物体的场景视频 , 实验中让机械臂去戳弄不同的物体 。 GelSight表面有一层薄膜 , 在接触物体的过程中会发生形变 , 进而采集到高质量的触觉数据 。 研究团队总共记录了195件物品的12000次触碰 , 这些物品属于不同类别 。 每个触摸动作包含一个250帧的视频序列 , 产生了300万视觉和触觉成对的图像的数据集—VisGel 。 根据此数据集 , 当模型辨认到接触位置的形状和材料 , 与参考图像进行比较 , 以识别触摸的位置和范围 。 文章插图

文章插图

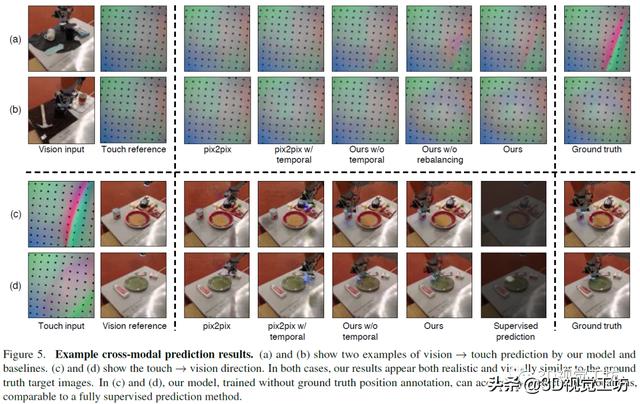

上图是本文模型和其他基线模型实验结果的可视化对比 , 该模型可以更好地根据视觉信息预测物体表面的触觉信息 , 也能够更好地根据触觉信息还原图像表面 。 文章插图

文章插图

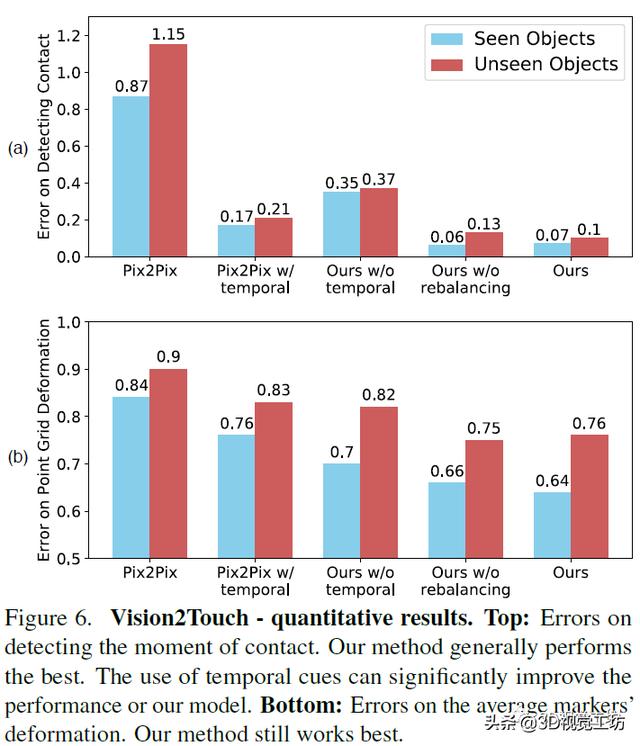

上图是从视觉到触觉的量化评测结果 。 a图的评价指标是测试机器人是否已经认知到触摸了物体表面的错误数 。 b图的评价指标是根据图像还原触觉点位置的失真错误情况 。 本文中的模型表现优于其它模型 。 文章插图

文章插图

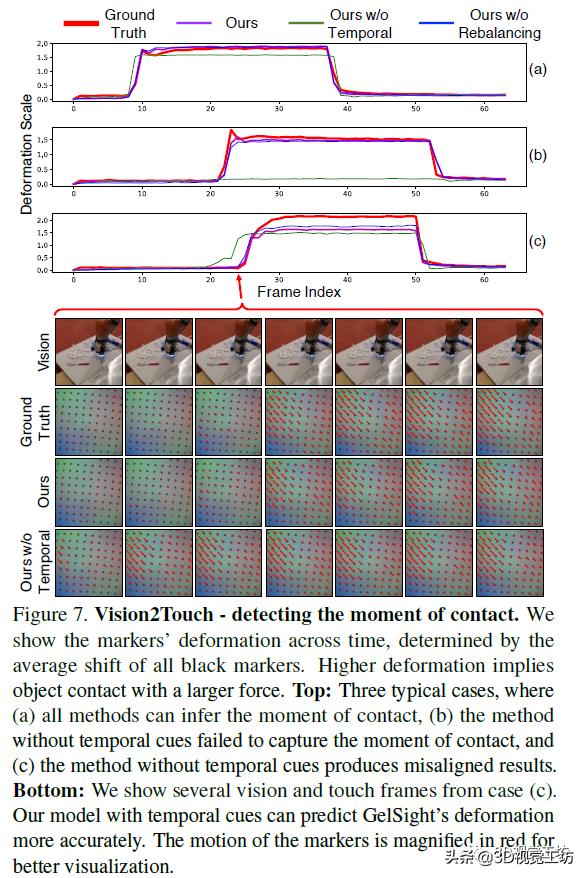

上图是从视觉还原触觉的情况 , 其中显示了标记随时间的变形 , 该变形由所有黑色标记的平均位移确定 , 较高的变形意味着物体以较大的力接触 。 下图是根据图像还原的触觉点阵信息 , 为便于增强可视化的效果 , 图片中的标记的运动以红色放大 。

该项工作提出了在视觉和触觉与条件对抗网络之间建立联系 。 当与外界互动时 , 人类非常依赖视觉和触觉的感官方式 。 该模型可以为已知物体和未知物体进行跨模态的预测 。 研究人员认为在将来 , 视触交叉的模式可以帮助视觉和机器人技术应用 , 例如在弱光环境下的物体识别和抓取以及物理场景理解 。

相关文章:

1.Vision-based Navigation with Language-based Assistance via Imitation Learning with Indirect Intervention;

2.Vision-based grasp learning of an anthropomorphic hand-arm system in a synergy-based control framework;

3.Visual Curiosity: Learning to Ask Questions to Learn Visual Recognition;

4.Vision-based grasp learning of an anthropomorphic hand-arm system in a synergy-based control framework.

Reference

1.Google AI Blog: Grasp2Vec: Learning Object Representations from Self-Supervised Grasping;

2.Improving Grounded Natural Language Understanding through Human-Robot Dialog;

- 当初|这是我的第一部华为手机,当初花6799元买的,现在“一文不值”?

- 双行合一|关于Word我们要了解的知识(12)

- S7|vivo S7的6400万有多强?带你感受“神奇动物在哪里”

- 模式|刚了解到无货源电商模式,淘宝好还是抖音小店好?

- 微信|微信转账点收款就能收到钱了?这个“秘密”要了解,很多人上当了

- 工地|“智慧工地”是什么?记者带你全方位了解

- 这些错误,程序员经常会犯,你了解过吗?

- 现场|逛展看未来丨展会现场还能这么玩?带你解锁萌娃的逛展“姿势”

- 快速概览 + 详细了解N:N聚类算法是如何应用的

- 微服务如何保证不会出现连锁反应?Go 实现的断路器了解下