从Bengio演讲发散开来:探讨逻辑推理与机器学习( 六 )

文章插图

文章插图

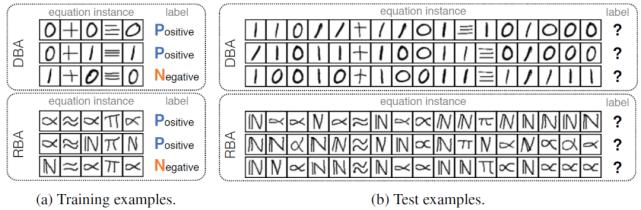

图 6. 手写方程解译任务的数据实例

本文实验中所使用的对比方法包括:

1)ABL , 机器学习模型由两层 CNN、一个两层多层感知器(MLP)和一个 softmax 层组成 , 逻辑诱因将 50 个位操作的计算规则集作为关系特征 , 决策模型为两层 MLP 。 实验中尝试了两种不同的设置:使用所有训练数据的 ABL-all 和仅使用长度为 5-8 的训练方程的 ABL-short 。

2)可微神经计算机(Differentiable Neural Computer , DNC) , 这是一个与记忆有关的深层神经网络 。

3)Transformer 网络 , 这是一个经过关注增强的深层神经网络 , 已经被证实在许多自然语言处理任务中是有效的 。

4)双向长短期记忆网络(Bidirectional Long Short-Term Memory Network , BiLSTM) , 这是目前应用最广泛的序列数据学习的神经网络 。 为了处理图像输入 , BiLSTM、DNC 和 Transformer 网络也使用与 ABLs 相同结构的 CNN 作为它们的输入层 。 所有的神经网络都是用一个从训练数据中随机抽取的验证集来调整的 。

除上述对比方法外 , 作者还进行了人类实验(human) 。 40 名志愿者被要求对从相同数据集中取样的方程图像进行分类 。 在参加测试之前 , 向各位志愿者提供了有关位操作的领域知识作为提示 , 但是具体的计算规则并不可知 。 作者没有使用与机器学习实验完全相同的设置 , 而是给了志愿者一个简化版本 , 其中只有 5 个正方程和 5 个负方程 , 长度在 5-14 之间 。

文章插图

文章插图

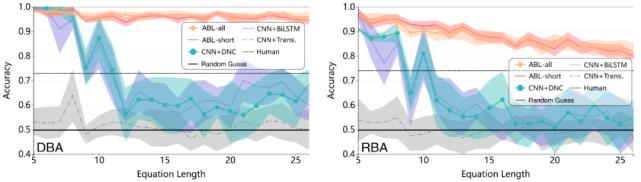

图 7. DBA(左)和 RBA(右)任务的实验结果

图 7 中的实验结果表明 , 在这两个任务中 , 基于 ABL 的方法明显优于其它进行比较的方法 , 并且 ABL 正确地学习了定义未知操作的符号规则 。 所有这些方法在 DBA 任务上的性能都比 RBA 好 , 这是因为 DBA 任务中的符号图像更容易区分 。 ABL-all 和 ABL-short 的性能没有显著差异 。 随着测试方程长度的增加 , 实验中用于比较的其它方法的性能迅速退化到随机猜测的准确度水平 , 而基于 ABL 的方法对未知数据的推导预测效果更好 。 一个有趣的结果是 , 人在这两个任务上的表现非常接近而且都比 ABL 差 。 根据志愿者的说法 , 他们并不需要区分不同的符号 , 在这种任务中人们非常容易出错 , 而机器在检查逻辑理论一致性方面是很擅长的 。 因此 , 应该更好的利用机器学习系统在逻辑推理方面的优势 。

2.1.5 文章小结

作为心理学中一种重要的认知模型 , 诱因已经引起人工智能领域的关注 。 现有的工作大多数是在符号域中将诱因性(Abduction)与归纳(Induction)结合起来 。 也有一些工作使用诱因性学习改进机器学习的效果 , 这些方法一般需要将逻辑背景知识调整为函数约束 , 或者在学习和推理过程中使用特别设计的算子来支持梯度下降 , 从而将逻辑推理简化为不同的连续优化问题 。

另一方面 , ABL 利用逻辑推理和试错搜索(Trial-and-Error Search) , 在不使用梯度的情况下将机器学习与原始的一阶逻辑连接起来 。 ABL 继承了一阶逻辑推理的全部能力 , 例如 , 它有可能放弃不在背景知识中的新的一阶逻辑理论 。 因此 , 可以直接向本文介绍的 ABL 框架中引入许多现有的符号人工智能技术 。

最后 , ABL 框架具有通用性和灵活性 。 例如 , 感知机器学习模型可以是一个预先训练好的模型 , 而不必须是从头开始学习的 。 机器学习的任务可以是半监督的 , 而不必须是完全没有标签的 。 逻辑推理可以包括二阶逻辑子句 , 从而可能能够实现递归从句和谓词自动发明 。 作者希望其对诱因性学习的探索能够推动构建统一的学习和推理框架 。

- NVIDIA GTC 2020秋季站主题演讲中文字幕版上线

- 2020世界VR产业大会云峰会演讲嘉宾 | 2018年图灵奖获得者,蒙特利尔大学教授Yoshua Bengio

- 智电网|MIDC开幕 雷军演讲,第四届小米开发者大会

- 南方PLUS|“人才日”演讲嘉宾陈宁:AI“追光者”的温暖地带

- 爱因儿科技|并提出解决方案,吴恩达演讲直指AI落地三大挑战

- 科技壹零扒|Bengio、杨强、唐剑领衔!探讨如何构建AI学术研究和产业落地的桥梁